Не удалось включить виртуальную машину synology

IT science

А вы знали, что на synology можно создать полноценную виртуальную машину? Можно делать снапшоты по расписанию и это все бесплатно! В платных функциях все гораздо круче, возможность создания кластера, с балансировкой нагрузки и т. д.

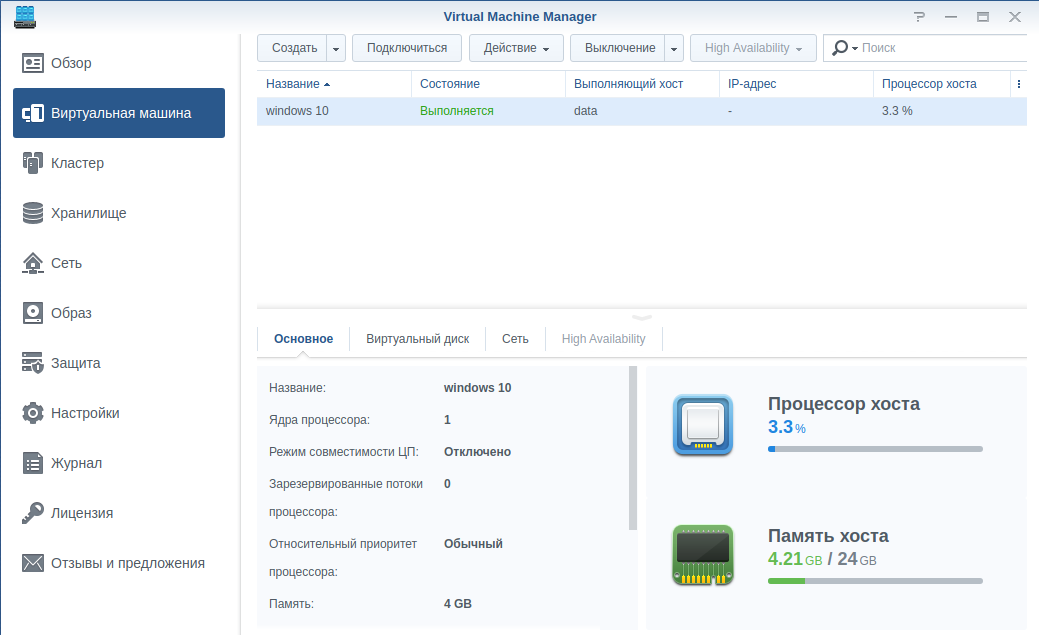

Вот пример создания виртуальной машины, поставим windows 10 на synology

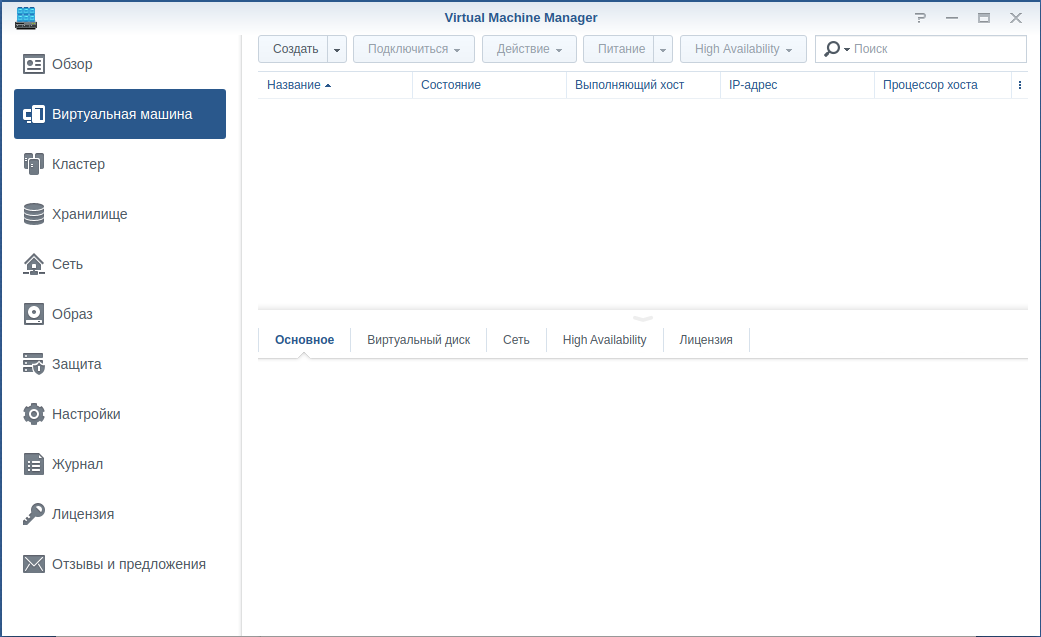

ставим пакет Virtual Machine Manager и запускаем его

переходим в «Виртуальные машины» и жмем кнопку «Создать»

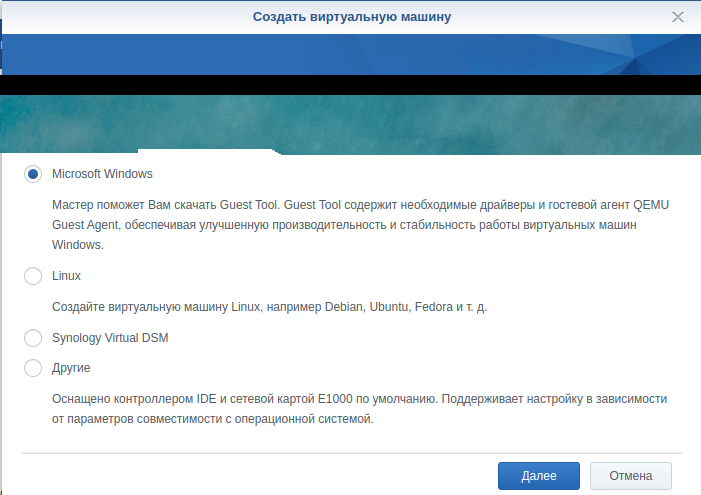

в нашем случае выбираем Microsoft Windows

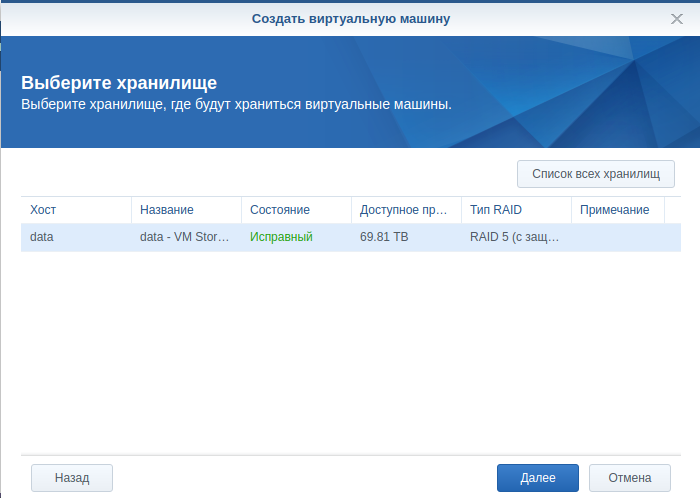

Хранилище — наше хранилище

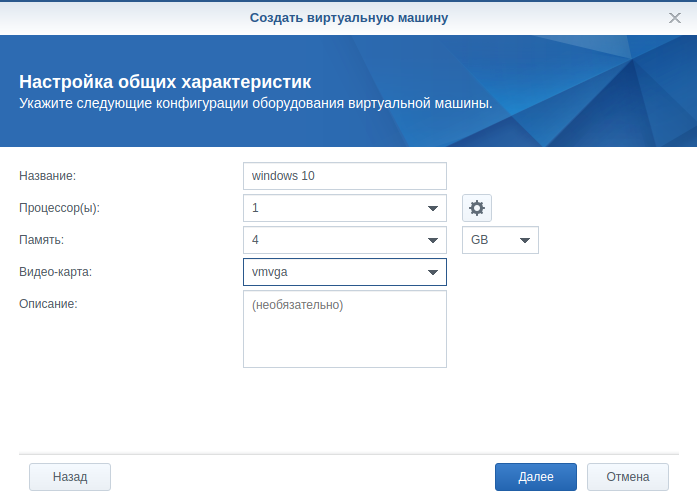

основные настройки: название виртуальной машины, сколько ядер процессора выделим, сколько оперативной памяти

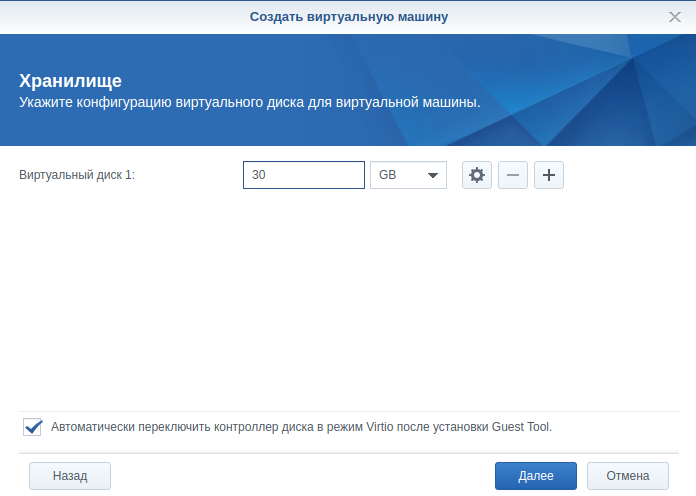

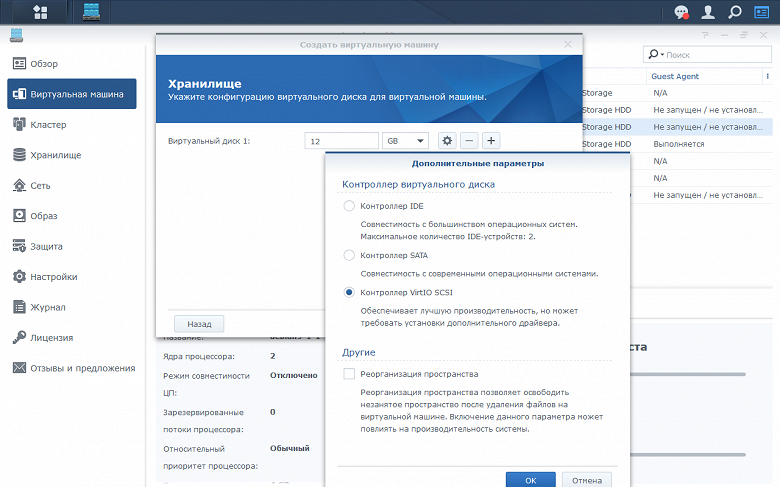

какого объема диск будем использовать, можно задать сразу много, т. к. диск только в процессе наполнения начнет занимать свободное место, а так почти ничего не весит.

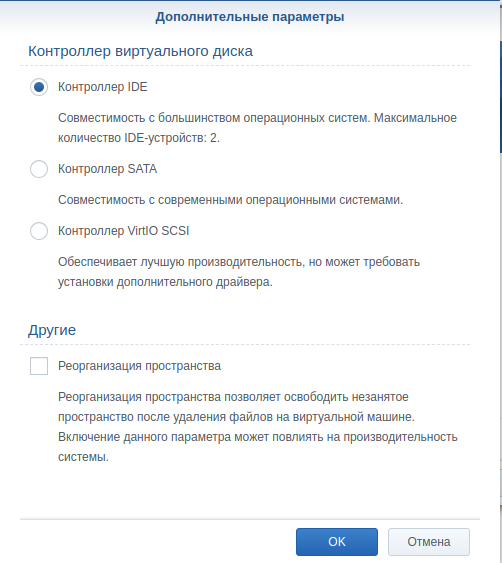

Если нажать на шестерню, то откроются дополнительные настройки, если для вас совсем уж критично свободное пространство, то можно поставить галочку «Реорганизация пространства», тогда при освобождении пространства на виртуальном машине, диск будет «сжиматься».

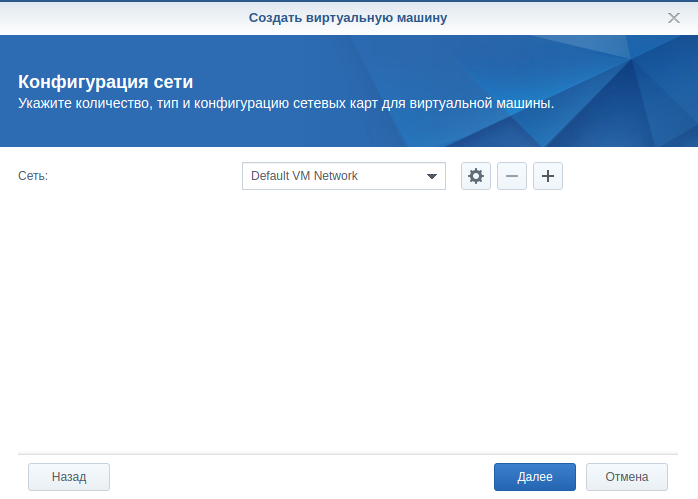

настройки сети, учтите, что вы можете создать свою изолированную сеть для виртуальных машин, ты и укажете ее, а пока прямой проброс наружу

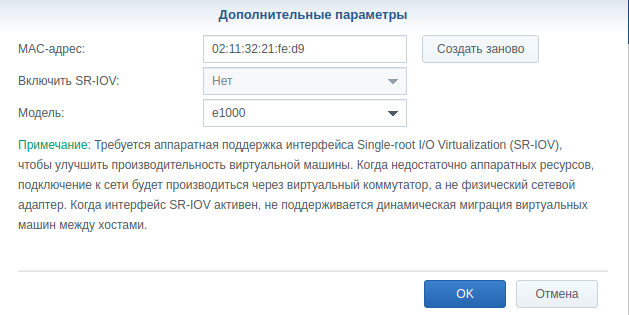

для виртуальных машин можно указать свой mac адрес, некоторые лицензионные сервера привязываются к mac адресу компьютера на котором запущены, и потребляют немного ресурсов, имеет смысл выносить их на виртуалки.

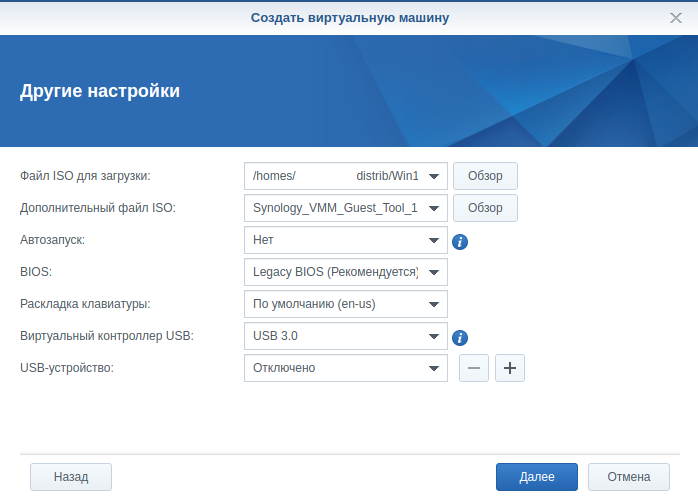

основные настройки виртуальной машины, указываем файл с образом системы для инсталляции (iso), обязательно после установки системы поставьте Guest tools, чтобы не возникало проблем с драйверами, автозапуск — виртуальная машина будет автоматически запускаться после старта сервера synology, остальное в нашем случае оставляем по умолчанию, добавлю лишь USB, чтобы была возможность пробрасывать в виртуалку USB донглы, воткнутые в synology.

далее настройка безопасности и старт виртуальной машины

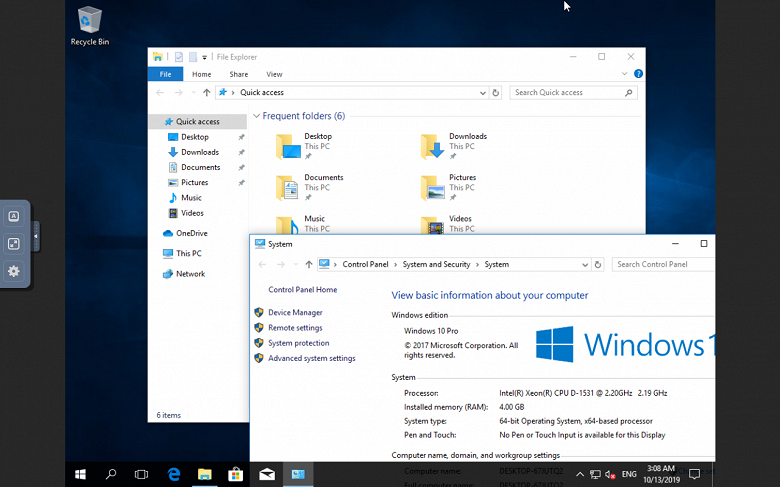

нажимаем кнопку «Подключиться» и у нас открывается отдельная вкладка в браузере с vnc клиентом, через который мы можем управлять виртуальной машиной.

Виртуализация на сетевых накопителях Synology: пакет Virtual Machine Manager

Оглавление

Технологии виртуализации уже давно получили распространение не только в датацентрах, но и в малом бизнесе и даже у домашних пользователей. Они позволяют эффективно решать многие задачи ИТ-инфраструктуры и существенно экономить ресурсы. На рынке сегодня представлено множество программных решений виртуализации, включая как крупных игроков с коммерческими продуктами, так и гипервизоры и системы виртуализации с открытым кодом. Так что пользователь может подобрать подходящий вариант по своим требованиям, возможностям и стоимости.

Компания Synology тоже решила поучаствовать в этой гонке и создала специальный пакет Virtual Machine Manager для решения данной задачи. Заметим, что в каталоге дополнительных пакетов есть и модуль легкой виртуализации Docker. Он способен работать на большем числе моделей (хотя и некоторые с поддержкой VMM в списке отсутствуют) и имеет возможность быстрого развертывания контейнеров из каталога готовых проектов. Для некоторых сценариев он может быть более удобным.

Формально пакет Virtual Machine Manager доступен для многих моделей уровня Plus и серии RS с платформой x86 начиная с 11-й линейки. Из актуальных устройств минимальным является DS218+, который оборудован двухъядерным Intel Celeron J3355 и имеет в базе 2 ГБ оперативной памяти. В любом случае, уточнить текущие совместимые модели можно на сайте производителя. Кроме того, некоторые ограничения встречаются и для отдельных функций. Например, при работе в кластере необходимо иметь на узле не менее 4 ГБ оперативной памяти для запуска виртуальных машин, иначе этот узел может работать только как хранилище образов дисков.

Если реально оценивать платформы, то конечно многое будет зависеть от того, что вы планируете запускать в виртуальных машинах. Для несложных сервисов с Linux может быть достаточно и одного ядра и 256 МБ оперативной памяти, но в общем случае, на наш взгляд, если хочется чувствовать себя относительно свободно — хорошо бы иметь в устройстве от четырех ядер и от 6 ГБ оперативной памяти. Заметим, что самая мощная на момент подготовки статьи модель сетевого накопителя от Synology оборудована двумя Intel Xeon Silver 4110 (8С/16T, 2,1/3,0 (Turbo Boost) ГГц) и поддерживает установку до 512 ГБ (в базе — 32 ГБ) оперативной памяти. Производитель рекомендует запускать на ней не более 32-х виртуальных машин. Так что даже она не конкурент специализированным серверам виртуализации, если вопрос в аппаратных характеристиках и большой, в том числе вычислительной, нагрузке, не говоря уже о таких сценариях, как VDI или использование GPU.

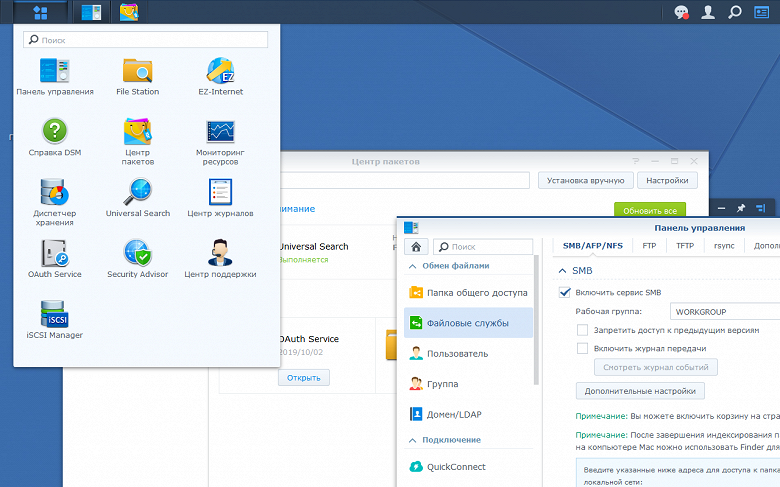

Установка программы не вызывает сложностей — открываете «Центр пакетов» и выбираете VMM для инсталляции. Напомним, что пакеты в DSM устанавливаются на существующий том, а штатной функции переноса пакетов на другой том в настоящий момент нет. Далее не забываем в панели управления выдать права на доступ к пакету для нужных пользователей.

Настройка системы

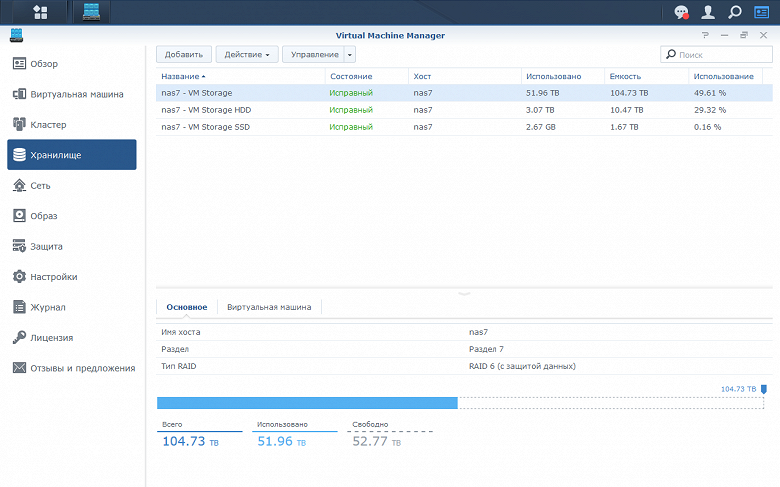

Для работы системы виртуализации необходимо настроить несколько ключевых параметров. Прежде всего, необходимо создать хранилище для размещения образов дисков виртуальных машин. Процедура несложная — достаточно выбрать один из существующих дисковых томов (обязательное требование — файловая система btrfs), придумать имя для этого хранилища и указать порог отправки предупреждений о снижении доступного свободного пространства.

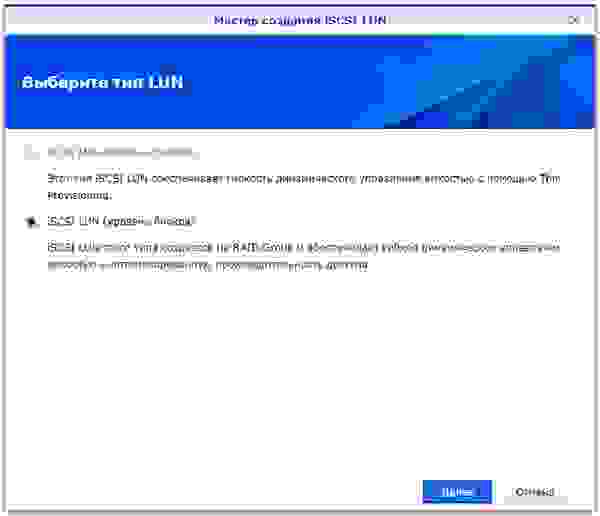

Подобных хранилищ на одном сервере может быть несколько, но только по одному на том. Сами папки, где хранятся образы, недоступны стандартными средствами сетевого доступа DSM и реализованы, вероятно, аналогичным thin iSCSI LUN образом.

Удобных средств работы с содержимом хранилищ в текущей версии VMM не предусмотрено. Только предоставляется информация о размещенных виртуальных машинах. Обратите внимание, что каждая машина может быть целиком записана только на одно хранилище. Так что сделать, скажем, большой виртуальный диск на HDD и быстрый на SSD в рамках одной машины не получится. Еще один не очень удобный момент — отсутствие информации о занимаемом именно образами дисков пространстве на томе.

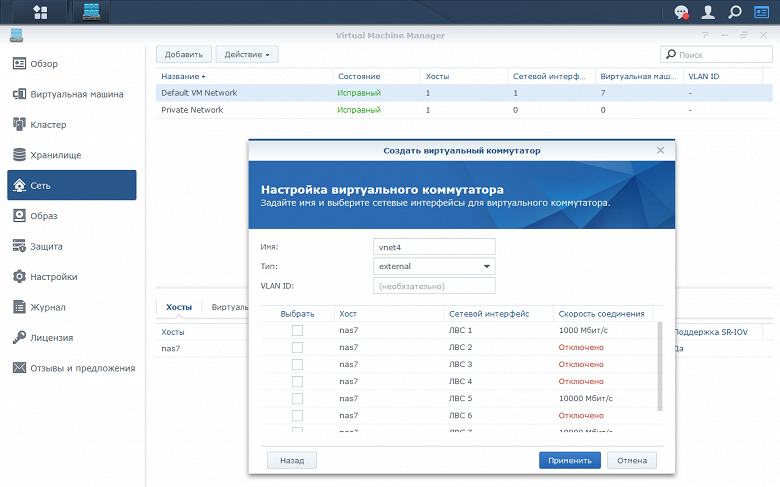

Вторая группа настроек — управление виртуальными сетевыми коммутаторами. Для каждого можно придумать имя и выбрать режим — с внешним доступом или только для работы внутри системы виртуализации. В первом случае также выбираются подключенные к нему физические сетевые карты сетевого накопителя и, при необходимости, устанавливается тег VLAN.

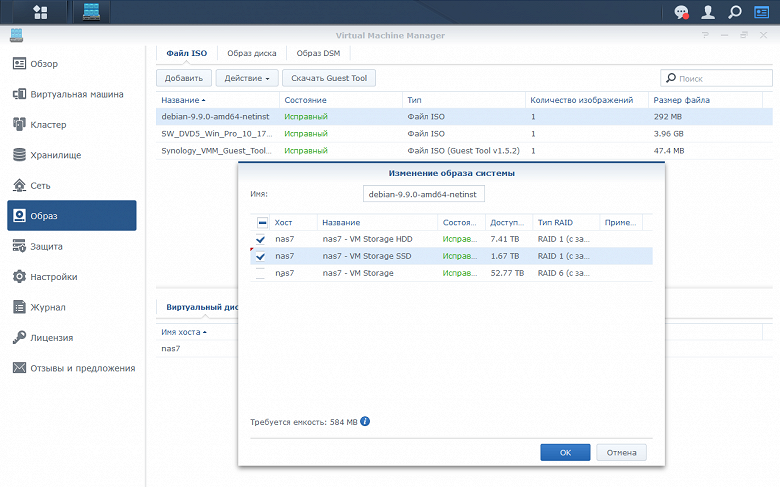

Для создания виртуальных машин обычно требуются образы загрузочных установочных дисков. Они размещаются в рамках созданных ранее хранилищ системы виртуализации путем загрузки с компьютера или из папки сетевого накопителя. В отличие от актуальных дисков самих машин, загрузочные образы можно штатными средствами копировать на все доступные хранилища. Загружать можно не только ISO, но и образы винчестеров в популярных для систем виртуализации форматах. Последние далее можно использовать при создании новых виртуальных машин (но не подключать к существующим). В этом же разделе загружаются из интернета образ для работы VirtualDSM и образ с драйверами виртуальных устройств для гостевых операционных систем. Заметим, что нельзя загрузить обратно с сетевого накопителя эти образы штатными средствами.

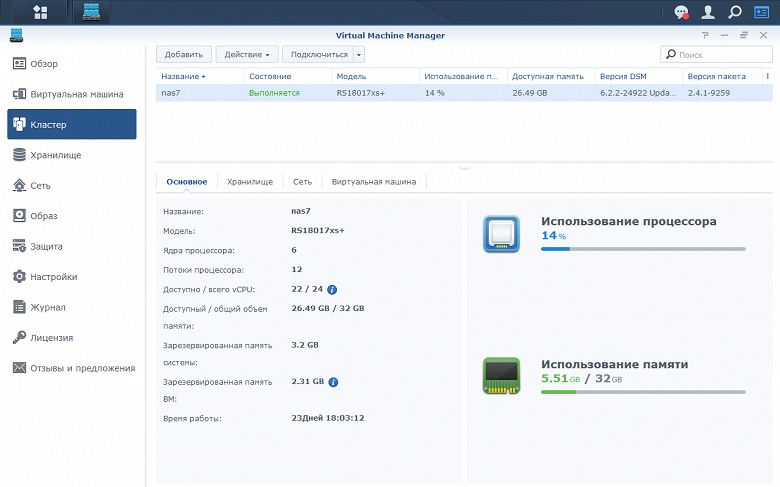

Отдельно стоит рассказать о работе в режиме кластера. Данная функция позволяет объединить до семи сетевых накопителей в систему с общим управлением, а также консолидировать вычислительные ресурсы, хранилища и сетевые интерфейсы. Кроме того, для кластера работает общая система уведомлений (только по электронной почте), независимая от настроек самих сетевых накопителей. Производитель рекомендует создать для обмена данным между участниками кластера отдельную сеть на выделенных сетевых интерфейсах. В любом случае, обязательно иметь статические IP-адреса на контроллерах участников кластера.

Создание виртуальных машин

Официально поддерживается установка в гостевых машинах операционных систем семейства Windows (от 7 до Server 2016) и множества вариантов Linux (включая CentOS, Fedora, Red Hat и Ubuntu). Но конечно никто не мешает попробовать и другие, в частности не было замечаний к работе Debian. Учитывая, что решение основано на известной связке QEMU и KVM, особых проблем быть не должно. Единственное, что стоит учитывать — производитель реализовал вариант работы с сервисом через веб-интерфейс. Что-то подправить в файлах конфигурации через командную строку, скорее всего, не получится.

Мастер создания виртуальной машины состоит из нескольких шагов для выбора параметров: типа гостевой ОС, места размещения виртуальной машины, имени и описания, процессора/оперативной памяти/видеокарты, накопителей (до восьми на одну виртуальную машину) и их интерфейсов, сетевых интерфейсов (включая тип контроллера и MAC-адрес), образов ISO для загрузки/инсталляции (одного или двух).

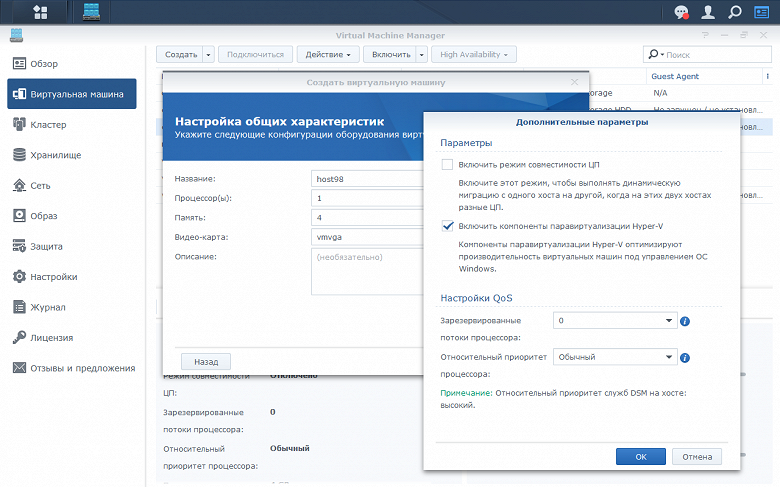

Кроме того, есть опции автоматического включения при загрузке сетевого накопителя, выбора типа BIOS (обычный или UEFI), трансляции USB-устройств в виртуальную машину. При настройке ресурсов процессора можно выбрать режим совместимости для возможности миграции на хосты с другими физическими процессорами, а также зарезервировать потоки и/или установить приоритет, если есть требования к производительности или отзывчивости. На последнем шаге можно выбрать пользователей и группы, которым будет разрешено работать с данной виртуальной машиной.

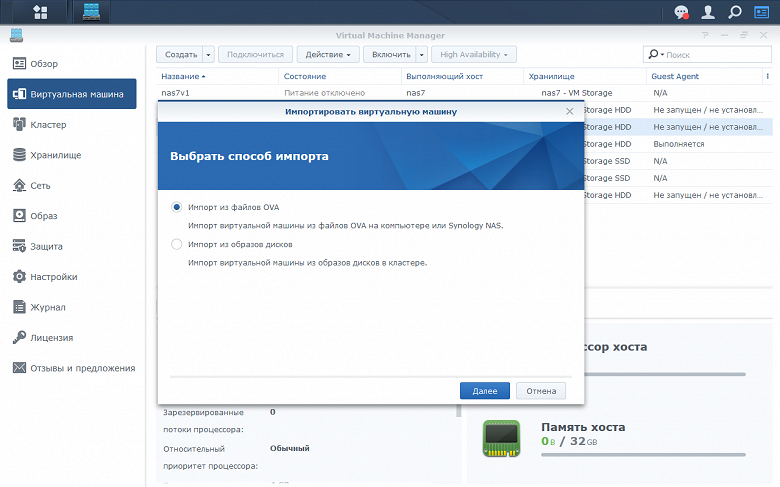

Кроме создания «с нуля» предусмотрены операции импорта из файлов формата OVA и запуск с ранее загруженных образов жестких дисков. Во втором случае всю остальную конфигурацию (процессор, память, сеть) нужно будет задать самостоятельно.

Управление виртуальными машинами

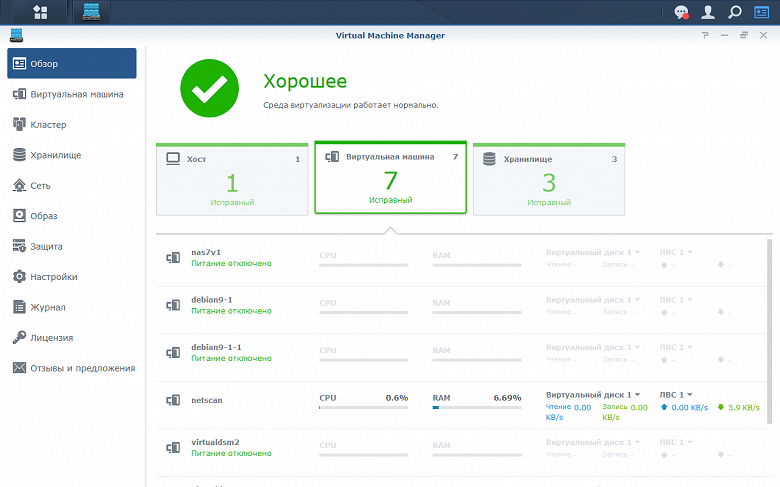

Быстро оценить текущее состояние сервера виртуализации можно на странице «Обзор».

Здесь приводится информация о хостах (кластере) и нагрузке на них, виртуальных машинах и потреблении ими ресурсов (включая процессор, память, диск и сеть), а также доступных хранилищах и свободном месте на них.

Непосредственно взаимодействие с консолью или рабочим столом виртуальной машины возможно прямо в браузере. Кроме того, предусмотрены варианты создания «общих ссылок» на доступ к виртуальным машинам, что существенно упрощает реализацию удаленного доступа. Достаточно будет отправить пользователю эту ссылку и, имея браузер, он сможет работать в виртуальной машине. В настройках ссылок можно установить ограничения — пароль, срок действия, число сеансов. Заметим правда что в базовой версии VMM можно иметь только одну ссылку на весь кластер, что конечно совсем не интересно. Но можно настроить портал VMM и раздать права пользователям NAS на доступ к конкретным машинам.

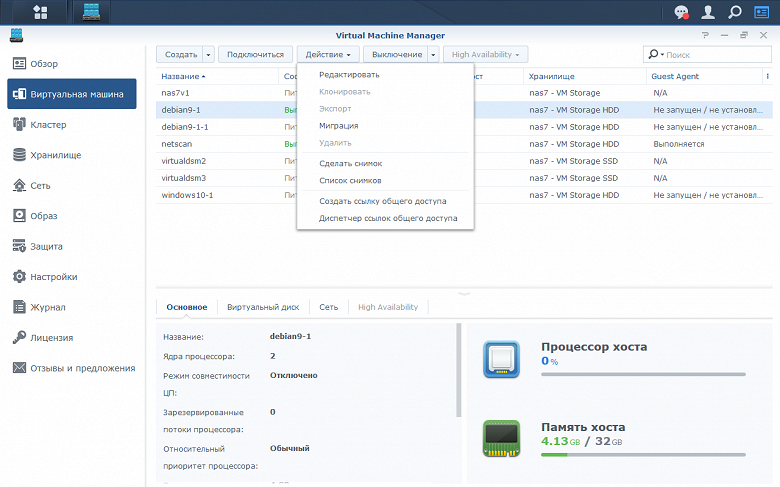

В зависимости от текущего состояния виртуальной машины для нее доступны следующие операции:

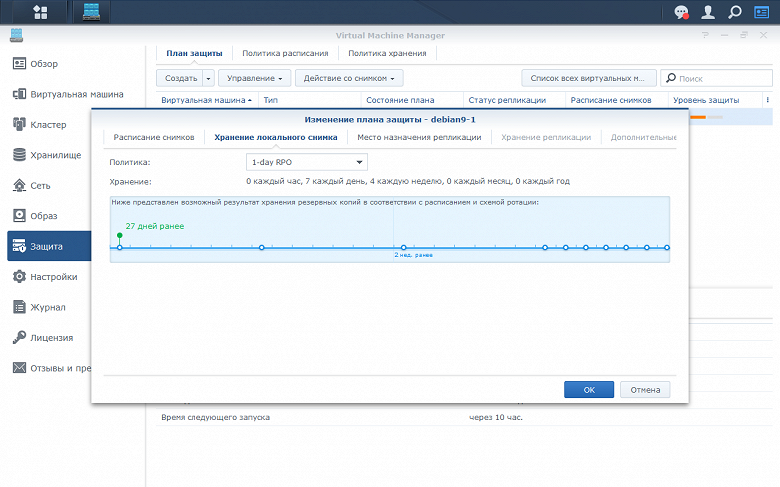

Как мы помним, одним из ключевых вопросов использования сетевого накопителя является защита данных. Поскольку штатными средствами файлы виртуальных машин недоступны, то для их защиты применяются специальные средства в самом VMM на базе технологии снимков. Кроме ручного запуска операции создания снимка, есть возможность настройки автоматического сервиса.

Для начала вам нужно определить политики расписания. Минимальный интервал при этом составляет 5 минут. Дополнительно можно указать дни недели и время начала и конца повторения. Далее создается политика хранения (чистки). Как и для снимков папок в DSM, здесь можно прописать или просто максимальное число снимков или придумать гибкий план, скажем хранить десять ежечасных копий, пять ежедневных, одну недельную и одну месячную.

В целом данное решение представляется достаточно удобным и гибким, однако надо понимать, что сами копии (снимки) хранятся на тех же томах, что и оригиналы. Так что в случае возникновения проблем с томами или самим устройством они могут быть потеряны. Частично эта проблема решена в версии VMM Pro.

В VMM ведется собственный журнал, который, к сожалению, недоступен через «Центр журналов» сетевого накопителя. Максимум, что предусмотрено — экспорт в формате CSV или HTML. Дополнительно есть возможность установки фильтра по уровню уведомлений и текстовый поиск.

Реализованные функции по управлению виртуальными машинами аналогичны другим популярным решениям, что, конечно не удивительно. Из плюсов отметим реализацию системы защиты, а из минусов — отсутствие возможности создания резервных копий на внешних ресурсах и ограничения по работе с дисковыми томами.

VirtualDSM

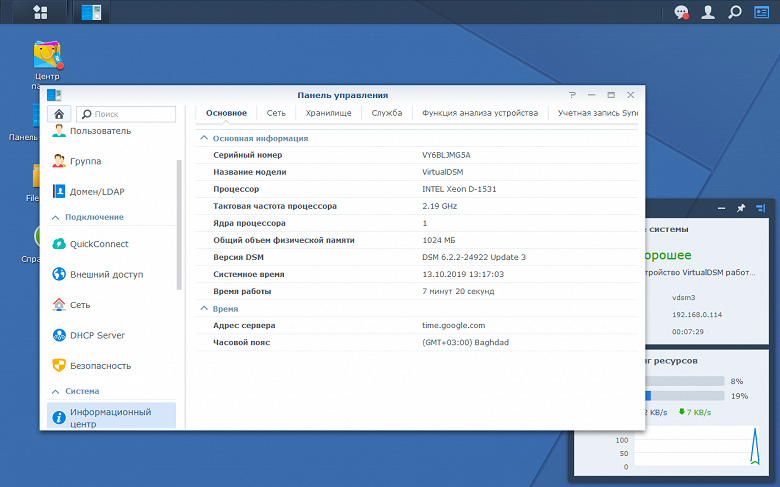

Интересной особенностью VMM является возможность запуска в виртуальной машине еще одной копии самой DSM. Это может быть востребовано на задачах тестирования и отладки, для выделения независимых ресурсов разным пользователям, отделам или даже компания, а также в случае необходимости использования решения с отличными от основной системы настройками (например, так можно реализовать сервер FTP с собственной базой аккаунтов). Обязательное требование к хосту, кроме поддержки VMM — наличие не менее 4 ГБ оперативной памяти.

При создании машины с VirtualDSM, как и для обычных виртуальных машин, нужно выбрать место ее расположения, название, число виртуальных ядер процессора, объем оперативной памяти (от 1 ГБ), дисковый том или несколько (от 10 ГБ каждый), сетевые интерфейсы и их параметры, режим автозапуска и права пользователей по управлению машиной.

После запуска VirtualDSM в окне управления виртуальными машинами можно узнать IP-адрес ее сетевого интерфейса и, как обычно, обратиться к нему в браузере для управления системой. Далее будет предложен знакомый мастер настройки, но только из одной страницы, на которой указываем имя сервера и аккаунт администратора.

Работа с виртуальным сетевым накопителем мало отличается от работы с реальным. Интерфейс, сервисы и функции в целом аналогичны «настоящему» устройству. Разницу можно найти только в работе с дисковыми томами — в системе используются готовые виртуальные тома. Интересно, что при желании можно увеличивать их размер даже без перезагрузки виртуальной системы.

В пакетах вы недосчитаетесь сервиса высокой доступности (High Availability Manager), MailPlus, PetaSpace и, конечно, самой VMM. Кроме того, в VirtualDSM нет поддержки управления питанием, внешних накопителей и других устройств. Учетная запись аккаунта Synology и службы QuickConnect, а также система уведомлений настраиваются независимо от основного устройства.

Отличия VMM Pro

Выше приводилась ссылка на отличия версии VMM Pro от обычной. Разберем таблицу по пунктам. Первая группа касается виртуальных ресурсов. В версии VMM Pro можно предоставить гостям в два раза больше виртуальных ядер, создать в тысячу раз больше коммутаторов, иметь не 32, а 255 снимков для каждой виртуальной машины, предоставить не одну, а шестнадцать ссылок общего доступа. Сложно сказать, насколько это действительно будет востребовано. Все будет зависеть от конкретных сценариев использования.

Следующим одним отличием версии VMM Pro является поддержка не только локальных снимков дисков виртуальных машин, но и их репликация на другие хранилища в пределах кластера.

При работе с VMM Pro, хост для запуска машины и хост для хранения образов ее дисков могут быть разными в кластере. Однако надо понимать, что скорость работы с удаленным хранилищем зависит от скорости сетевого подключения участников кластера.

Пакет VMM несовместим с сервисом Synology High Availability, так что в нем предусмотрены собственные средства обеспечения высокой доступности. При наличии активной подписки VMM Pro и не менее трех хостов в кластере вы можете включить данный сервис для выбранных виртуальных машин. Для этого вы определяете активный и пассивный сервера, на которых происходит непосредственно запуск виртуальной машины, а для хранения ее данных требуется еще один сервер. Заметим, что при работе такой виртуальной машины на пассивном сервере будут предварительно зарезервированы ресурсы для нее. В зависимости от типа возникшей проблемы происходит или динамическая миграция виртуальной машины без прерывания работы с активного на пассивный сервер или ее перезапуск на пассивном сервере. При необходимости можно осуществить и принудительную миграцию. Обратите внимание, что миграция несовместима с SRV-IO (может быть использовано для сетевых контроллеров), а подключенные к виртуальной машине USB-устройства будут отключены. Кроме того, необходимо использовать сетевые накопители на одинаковых процессорах или включить режим совместимости для виртуальной машины. Еще одним отличием версии VMM Pro является поддержка не только локальных снимков дисков виртуальных машин, но и их репликация на другие хранилища в пределах кластера. В настоящий момент возможности данного сервиса, на наш взгляд, отстают от предлагаемых в коммерческих продуктах.

Заключение

Пакет Virtual Machine Manager позволяет даже неподготовленным пользователям начать работать с системой виртуализации для реализации своих задач. Решение получилось достаточно удобным и универсальным. При этом «из коробки» вы получаете неплохой набор возможностей, включая подключение к рабочим столам из браузера, защиту виртуальных машин по технологии снимков, настройку сетевых коммутаторов, импорт готовых образов виртуальных машин и другие. Конечно, это заметно проще, чем работа в консоли или установка гипервизора на выделенный сервер. В общем случае, сравнивать данное решение по стоимости с коммерческими продуктами нет смысла. Они играют в разных сегментах. Подобные оценки можно провести, если только речь зайдет о разработке проекта под определенные задачи и требования.

С другой стороны, в текущей линейке сетевых накопителей компании обычно используются относительно слабые платформы, которые хорошо справляются с задачами сетевого управления данными, однако для «настоящей» виртуализации подходят плохо. Конечно, данный продукт справится с такими нетребовательными задачами, как, к примеру, сервер автоматизации, сервер удаленного доступа, служебные сетевые сервисы (DNS, LDAP, RADIUS и т. п.), однако для многих из них уже есть готовые пакеты в составе самого DSM. Работа именно в отдельной виртуальной машине в данном случае может быть интересна если хочется полного контроля и/или независимости. При этом рассчитывать, что вы сможете использовать не топовые модели сетевых накопителей для комфортной удаленной работы с полноценными настольными операционными системами не стоит. Все-таки виртуализации нужны и ядра и оперативная память. Так что если вам нужна именно виртуализация, то сервера сходной по этим параметрам конфигурации могут быть и дешевле.

Из наиболее существенных замечаний по функциям VMM отметим отсутствие гибких средств доступа к хранилищам образов, возможности добавления образов дисков к существующим машинам, резервного копирования на сетевые ресурсы по стандартным протоколам.

Дополнительное лицензирование версии VMM Pro в данных условиях выглядит достаточно логично, поскольку расширенные функции нужны не всем. Текущая реализация, даже учитывая стоимость сетевых накопителей верхнего уровня, выглядит достаточно интересно на фоне коммерческих решений, однако последние предоставляют существенно больше возможностей и по существенно более высокой цене.

Решение VirtualDSM тоже выглядит интересно. Оно вполне может найти себе место не только как отдельный продукт для сдачи в аренду клиентам дата-центров, но и в малом бизнесе. Например, если хочется иметь изолированную среду для тестирования или независимое хранилище для департамента или внешних сотрудников.

Виртуализация Synology на примере DS220+

Виртуализация Synology на примере DS220+

В NAS устройствах от компании Synology работающих на процессорах x86 архитектуры можно запускать виртуальные машины. Это могут быть как обычные виртуальные ПК на операционной системе Windows, так и серверные версии ОС на базе ядра Linux и даже виртуальный DSM.

В Synology это называется Virtual Machine Manager (VMM) — интуитивно понятное программное обеспечение гипервизора, которое позволяет серверам Synology NAS запускать различные операционные системы на виртуальных машинах

Нужно отметить, что VMM есть бесплатная версия и версия VMM Pro, для активации которой нужна соответствующая лицензия. О различиях в этих версиях можно ознакомиться тут.

Вы должны понимать, что каждая виртуальная машина потребляет определенное выделенное ей количество ресурсов. Поэтому запускать бесконечное количество виртуальных машин не получится. На этой странице есть рекомендации Synology о таком количестве для каждой модели NAS. Согласно этой информации мой NAS DS200+ с 6Г ОЗУ поддерживает максимально 2 виртуальные машины. Оно и понятно, процессор 2 ядра не очень производительный, но для такого маленького домашнего устройства думаю больше и не нужно.

Так же данный гипервизор потребляет по мимо выделенных ресурсов еще дополнительные нужные для его работы мегабайты ОЗУ: для каждой виртуальной машины требуется 128 МБ; для каждого виртуального требуется 80 МБ; для каждого виртуального диска требуется 32 МБ.

Например если выделить для виртуальной машины 2 процессора + 2ГБ ОЗУ + 2 виртуальных диска, то она будет потреблять 2400МБ оперативной памяти ( 128 МБ + 80 МБ x 2 + 2 ГБ + 32 МБ x 2 = 2400 МБ )

Для демонстрации VMM я сделал скриншоты для просмотра каждой вкладки и настроек

Установка QEMU Guest Agent в Linux

apt-get install qemu-guest-agent

Гибридное хранилище для дома «из коробки» и возможности High Availability от Synology

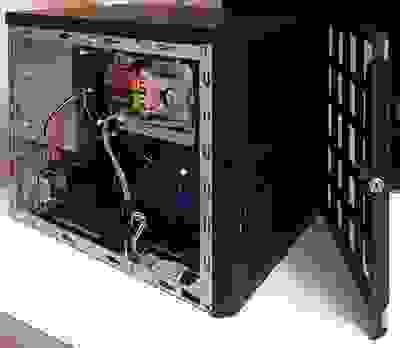

Стоимость необходимых комплектующих для новой хранилки была соизмерима со стоимостью Intel NUC, который я присматривал для сервера видеонаблюдения. Поэтому я решил отказаться от существующей Synology в пользу брата (и использовать её как удалённый бэкап), а себе собрать систему «всё в одном» на базе DSM.

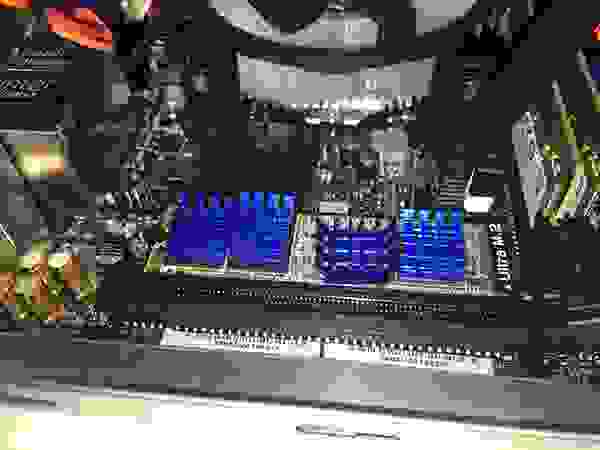

В качестве платформы выбрал всем известный корпус Chenbro SR30169 на 4 корзины с горячей заменой. Материнскую плату выбирал по кол-ву LAN и форм-фактору — из свежих нашёл только эту — Asrock Z370M-ITX/ac. Два сетевых интерфейса, поддержка 8-го поколения процессоров, а самое главное — 6 х SATA на борту, а это значит, что можно ещё подключить SSD под кэш на чтение. Процессор i3-8100 c 4 ядрами и память 16Гб (с запасом для виртуалок). Диски оставил от прежней Synology — 4 x 6Tb.

Сборка платформы

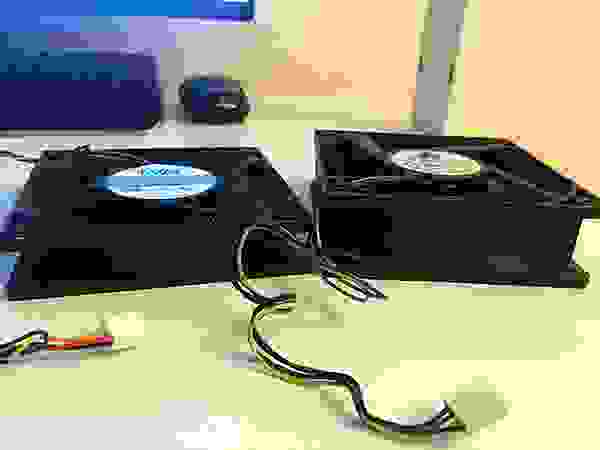

При использовании на столе, этот корпус нормально охлаждает 4 диска в корзинах горячей замены. Но в шкафу под нагрузкой температура дисков доходила до 48-50 градусов. Поэтому я решил заменить штатный 120-ый вентилятор на более производительный.

1,5А-вентилятор снизил температуру дисков до 36-40 градусов. После доработки вытяжки из шкафа, уверен, что температура еще существенно упадёт.

Один SSD 2,5″ под кэш я установил на стандартное крепление с одной стороны дисковой корзины. Его температура не превышала 30-32 градуса, и это при том, что он никак активно не охлаждается.

В качестве диска под пакеты DSM и быстрого раздела я установил M.2 SATA SSD в слот на материнской плате. Накопитель нагревался до 50 градусов, не смотря на прямой обдув. Я решил проблему установкой на него нескольких радиаторов — температура снизилась на 10 градусов.

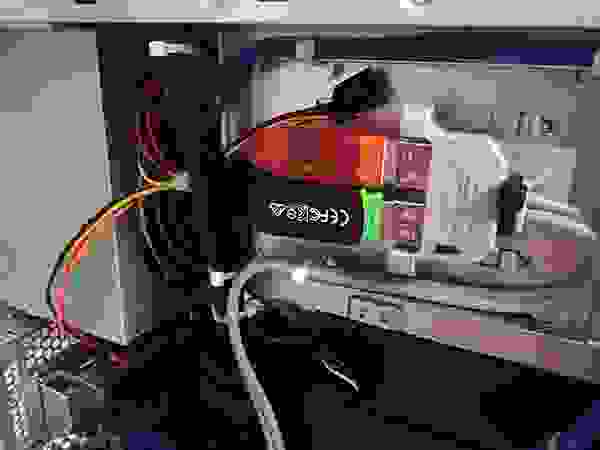

У меня 2 постоянно активных USB-устройства: загрузчик XPenology и ключ Guardant от Macroscop. Чтобы не занимать внешние разъёмы я пристроил эти устройства внутри корпуса.

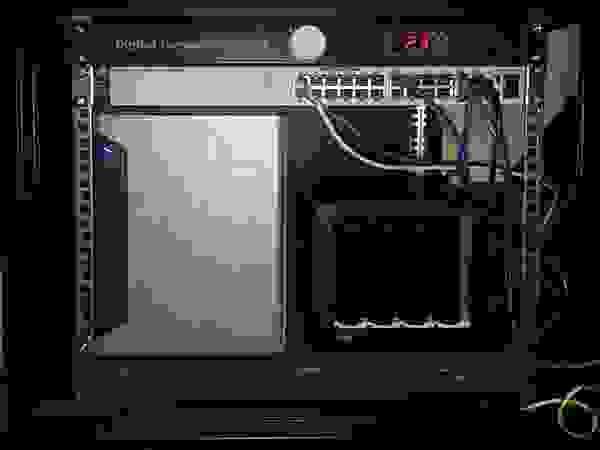

Готовое хранилище с высокой производительностью процессора и максимально компактными размерами со скрипом, но вписалось в свободные 6 юнитов.

Подготовка загрузчика

Для того, чтобы установить DSM нужен загрузчик, который представит железо в качестве СХД Synology.

В интернете много инструкций на эту тему, поэтому вдаваться в подробности не буду, но если появятся желающие — могу описать детали подготовки загрузочного устройства.

После установки валидной пары серийник/MAC и прочих параметров, образ для DS3615 заливается на любое устройство с которого можно грузиться. Можно использовать SATA DOM, но так как у меня SATA-порты на перечёт — я остановился на классическом варианте — USB флешке.

В BIOS необходимо удалить все загрузочные устройства кроме USB, а в параметрах SATA включить функцию HotPlug, чтобы новые диски определялись «на горячую», не дожидаясь перезагрузки.

Запуск

При первом запуске ищем устройство при помощи find.synology.com. Если этот вариант не работает, то скачиваем Synology Assistant с официального сайта и сканируем сеть с помощью него.

После подключения по адресу хранилища к веб-интерфейсу, система предлагает произвести установку DSM. Если на шаге подготовки загрузчика всё было сделано грамотно — установку можно произвести не из файла-образа, а сразу с официального сайта в автоматическом режиме.

Система форматирует все установленные носители и на каждом создаёт область для DSM. Таким образом, переставив диски в другое хранилище Synology или Xpenology можно произвести миграцию с сохранением всех данных и системных настроек.

Прежде чем реализовать всё дома, я долго тренировался на различных платформах. Система без проблем мигрировала с компа на базе Celeron J1900 на сервер с 2 х E5-2680V4, а после на древний экспонат на базе 2 х E5645. Если есть виртуалки, то разумеется необходимо перед установкой ОС на виртуальную машину включать режим совместимости процессора. Вероятно это снижает производительность, т.к. процессор в виртуалке становится не реальный, а универсальный. Но зато, миграция проходит без трудностей и BSOD.

Настройка

Работа через загрузчик Xpenology почти не имеет ограничений по сравнению с оригинальным устройством. Из отличий можно отметить отсутствие функции QuickConnect — нет удалённого доступа к хранилищу через учётную запись Synology. Но у меня внешний IP — это ограничение для моего случая не актуально.

Также некорректно отображается модель процессора и кол-во ядер — информация зашита в загрузчике и всегда будет выглядеть как для DS3615xs: INTEL Core i3-4130 / 2 ядра. Но зато, частота определяется актуальная. Эта особенность не мешает определять и использовать гипервизору реальное кол-во ядер. Но и тут есть ограничения — Virtual Machine Manager увидит не более 8 ядер в системе. Поэтому ставить DSM на многоядерные конфигурации бессмысленно.

С объёмом ОЗУ всё в порядке — определялся и использовался весь объем (на практике до 48ГБ).

Интегрированные сетевые контроллеры определяются без проблем, а вот WiFi у меня не нашёлся. Предполагаю, что эта проблема может решиться добавлением драйверов, но, к сожалению, мои познания в Linux не позволяют мне этого реализовать. Если из читателей этой статьи найдётся человек, который сможет описать инструкцию по добавлению в сборку драйверов на беспроводной контроллер — я буду признателен.

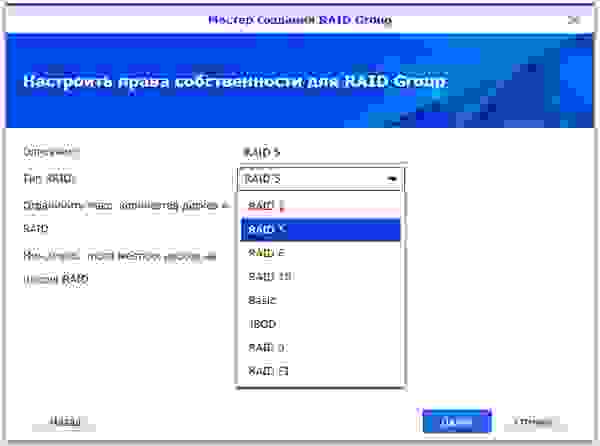

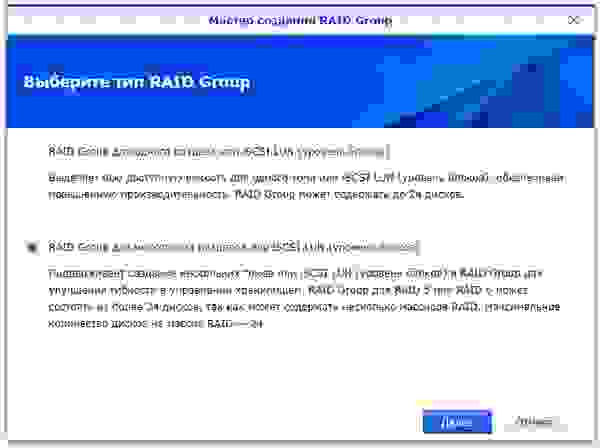

Перед началом использования системы хранения необходимо создать RAID-группы. После перехода на первую Synology я оставил «зеркало», а 2 дополнительных диска пустил на Hot Spare. При переходе на Xpenology выбрал RAID5+HS, но потом добавил 4-ый диск в RAID6. Всё равно крутится и греется — пусть хоть с пользой.

Так как DSM обеспечивает как файловый, так и блочный доступ — перед созданием RAID-массива необходимо определиться с требованиями к типу будущего хранилища.

Я сразу создал несколько LUN для использования на домашнем мини-ПК и ноуте. Файловая шара — это хорошо, а диск с блочным доступом для установки программ — ещё лучше.

Далее создаётся необходимое кол-во LUN и разделов на RAID-группах, папки общего доступа и прочее. Описывать всем известный функционал Synology нет смысла. Все доступные пакеты расширения с описанием функционала доступны на официальном сайте.

Под мои задачи актуальными были следующие пакеты:

Virtual Machine Manager — собственно из-за него вся затея с Xpenology.

Пакет имеет более расширенный функционал, чем я использую, поэтому я решил протестировать его работу на нескольких нодах в режиме High Availability Cluster.

Но, вскоре был разочарован. Для кластера необходимо 3 ноды: активная, пассивная и хранилище. Автоматическая миграция виртуальных машин при выходе из строя активной ноды поддерживается только на виртуальных машинах Synology Virtual DSM — с виндой и прочими ОС не прокатит. Какой смысл на DSM поднимать кластер с виртуальными DSM я так и не понял…

В общем, более чем банальный гипервизор, я этот модуль не раскрыл для себя.

VPN Server — поддерживает PPTP, OpenVPN и L2TP/IPSec

PPTP, как у меня получилось выяснить, поддерживает только одно подключение бесплатно — его я использую для связи с удалённой Synology для бэкапа.

OpenVPN использую для подключения с iPhone и рабочего компьютера, а также для удалённого подключения LUN по iSCSI.

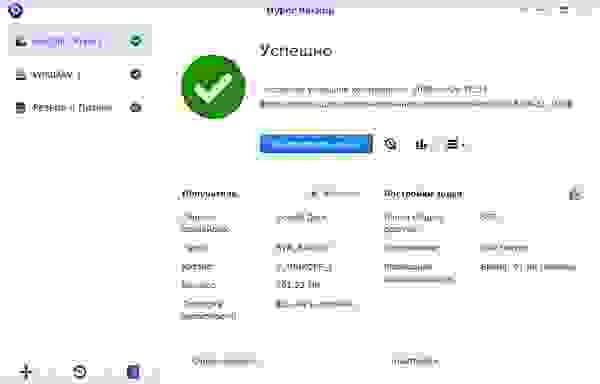

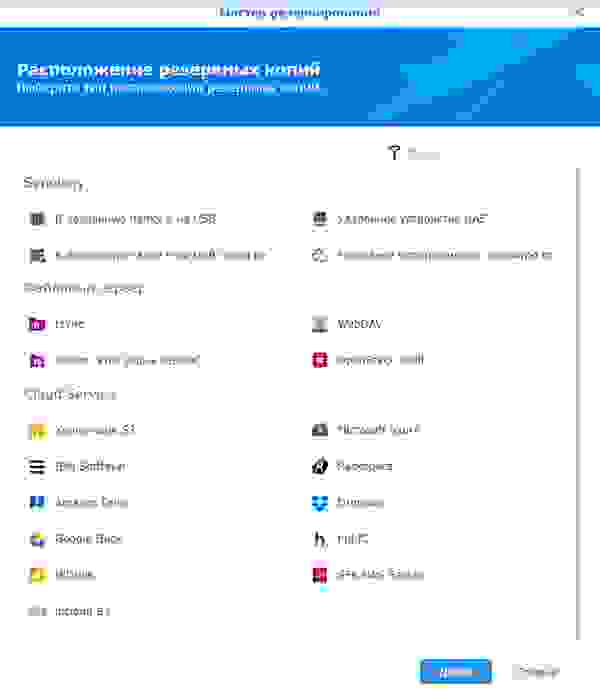

Hyper Backup — удобный, функциональный и, в то же время, лаконичный сервис резервирования.

Можно резервировать как папки так и LUN. Файловый бэкап можно сливать на другую Synology, на другой NAS и в облака. LUN резервируется только локально или удалённо на устройство Synology. Поэтому, если требуется бэкап луна в облако, как я понял, можно вначале его забэкапить в локальную папку, а уже её в облако.

Я использую 3 типа резервирования:

Выбрав метод и указав данные для авторизации на удалённом устройстве, помечаются папки для резервирования.

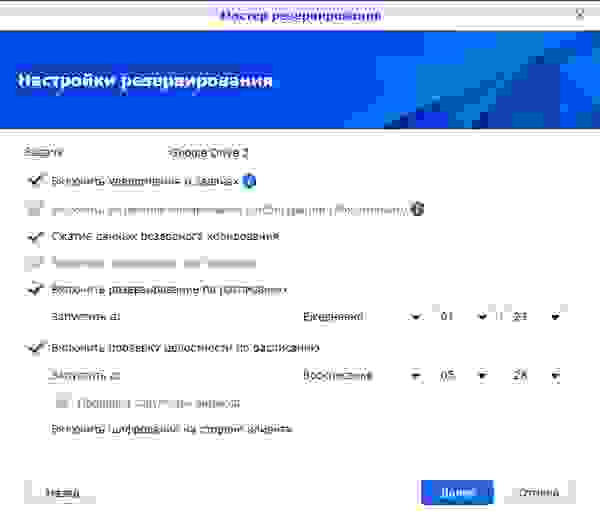

Далее настраивается расписание и параметры бэкапа.

Если выбрать шифрование, то потребуется ввод пароля на доступ к бэкапу. После создания задачи автоматически выгружается файл-ключ, который может заменить забытый пароль при восстановлении данных.

Шифрование на стороне клиента, на мой взгляд, очень полезно при резервировании в публичное облако. Если с архивом Ваших фото Google может делать всё что угодно, то зашифрованный бэкап тех же фото будет мало кому полезен.

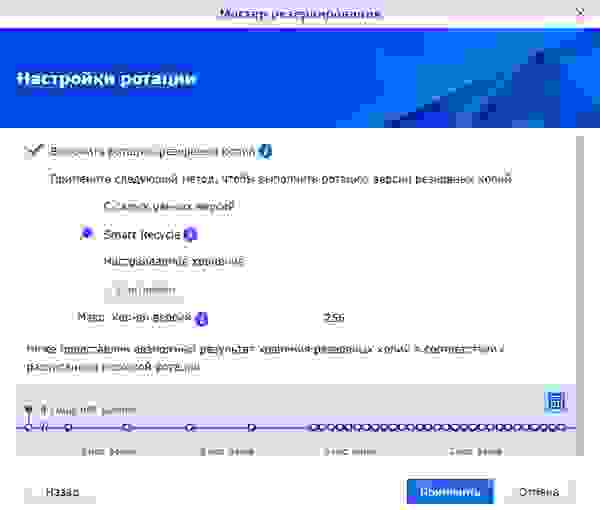

Далее включается/настраивается ротация резервных копий.

Я использую режим Smart Recycle, но можно установить график ротации копий инкрементного резервирования на свой лад.

Модуль Hyper Backup работает только в паре с обратной частью — модулем Hyper Backup Vault

Этот сервис принимает удалённые копии и отвечает за их хранение.

Восстановление данных, приложений и настроек возможно как на текущей системе (при повреждении массива, утере данных и пр.), так и на новой такой же или абсолютно другой Synology или Xpenology. Для восстановления, при создании задачи резервного копирования, необходимо указать, что это не новая задача, а подключение к уже существующей. Hyper Backup увидит на удалённой машине необходимый бэкап и предложит выбрать версию копии по дате и времени.

На данный момент, это пока весь функционал, который мне удалось освоить и использовать.

Домашняя Xpenology продолжает работать без проблем — периодически обновляется DSM и пакеты, вычислительных мощностей с запасом, а по деньгам она обошлась мне в 1,5 раза дешевле Synology DS916+.

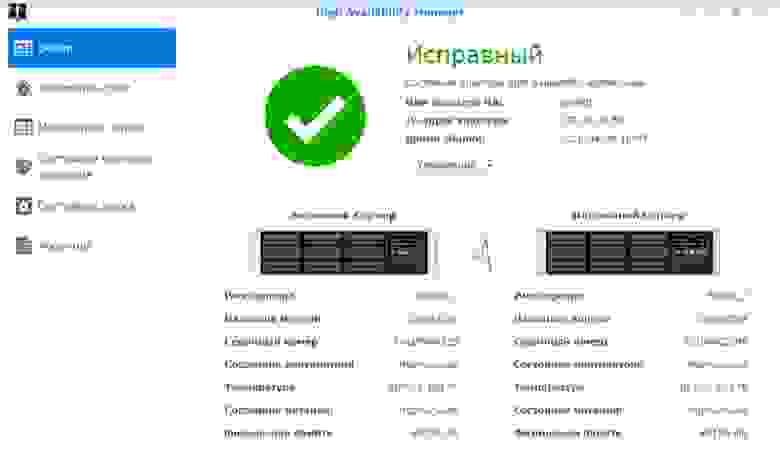

Synology High Availability Cluster

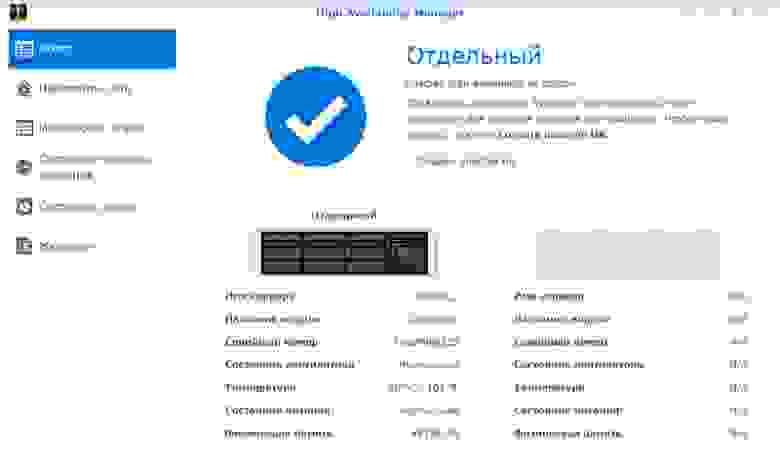

У меня вызывал интерес сервис High Availability Manager, который оказался не совместим с сервисом Virtual Machine Manager, так как тоже делает кластер, но уже по другому.

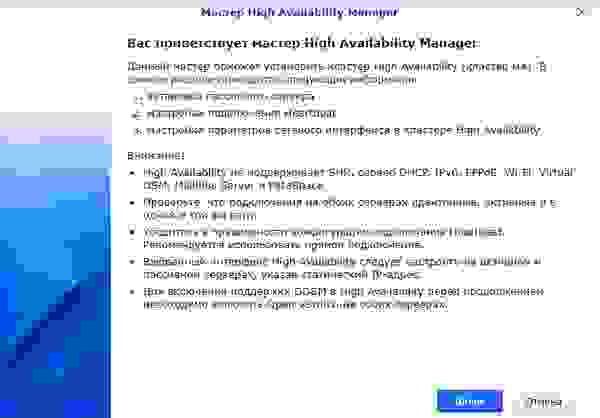

Для тестирования я поднял Xpenology на двух серверах на базе 2 x Xeon E5645. Сервера для этого кластера должны быть идентичными, IP-адреса статическими, второй порт каждого сервера соединён друг с другом напрямую (можно и через коммутатор, но эффективней так).

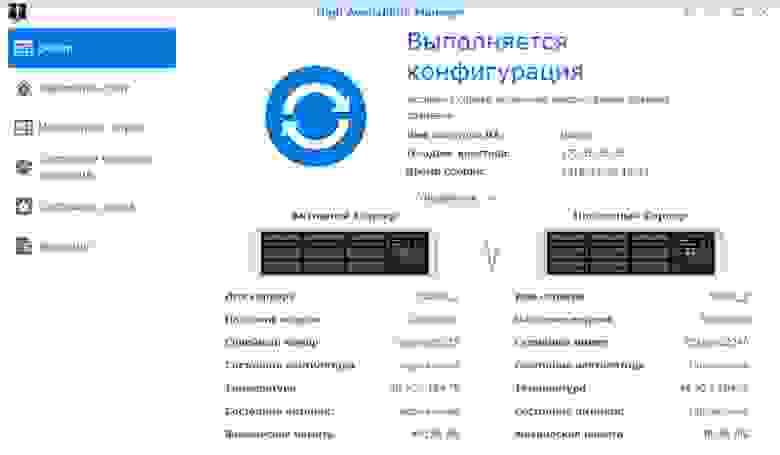

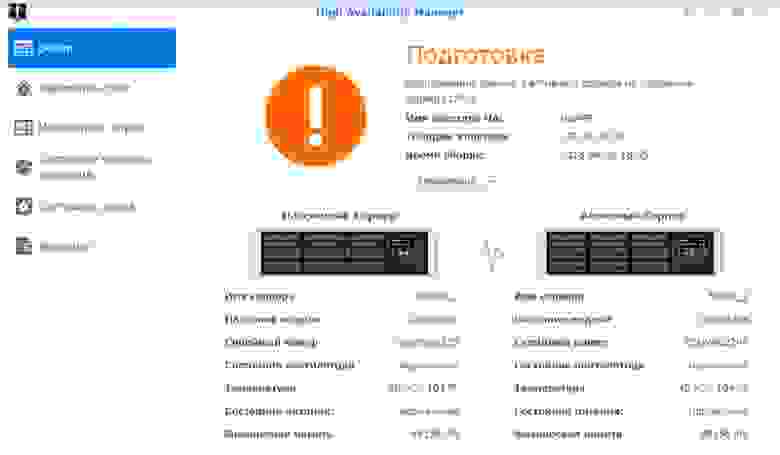

После подключения второй ноды тестируется подключение Heartbeat. Далее назначается имя кластера и статический локальный адрес. Во время слияния нод, конфигурация пассивной ноды приводится к состоянию активной, синхронизируются приложения, хранилище и данные. Обе ноды отваливаются для доступа по сети, и после создания — кластер доступен по своему новому адресу.

В зависимости от объема существующих данных, полная синхронизация массивов может занять немало времени, но кластер доступен к работе без отказоустойчивости уже через 10 минут после начала слияния.

После того как вторая нода будет полной копией первой, активируется режим высокой доступности.

Для проверки работы отказоустойчивости я создал LUN, подключил его по iSCSI и запустил объёмную задачу чтения и записи со своего ПК, совместно с проигрыванием видеоролика.

В момент активности я обесточил главный сервер. LUN не отвалился, процесс копирования не прервался, но приостановился секунд на 10-15 — это время потребовалось пассивному серверу взять роль активного и запустить упавшие службы. Воспроизведение также приостановилось на несколько секунд. После кратковременного простоя копирование данных и проигрывание видео продолжилось в штатном режиме без необходимости перезапускать процесс. Такой «провал» в большинстве случаев будет не заметен пользователям, если только не ведется воспроизведение видео без буферизации или запущены какие-либо другие процессы, требующие непрерывного доступа к хранилищу.

После включения первой ноды, она переходит в режим пассивного сервера. Запускается фоновый процесс синхронизации, после завершения которого режим высокой доступности снова восстанавливается.

Для замены ноды, в случае полного выхода из строя, необходимо освободить пассивный сервер.

Процедура привязки пассивного сервера аналогична процедуре создания кластера, вначале синхронизация — затем High Availability. Только при одном исключении — добавление происходит уже из интерфейса кластера, а не активного сервера.

Из минусов такого решения — высокая избыточность, ну а плюс — честная отказоустойчивость.

Основные затраты выпадают на диски, но для любителей RAID10 самое оно! Зазеркалировать две ноды с RAID5 или RAID6 — по дискам будет почти одно и то же. А вот отказоустойчивости прибавится кратно.

Понятное дело, что это не уникальный функционал, но зато «из коробки» и не требует особого опыта и знаний — только веб-интерфейс. А, учитывая, что Xpenology работает на любом железе, получается весьма интересное, производительное и отказоустойчивое решение для личного использования.